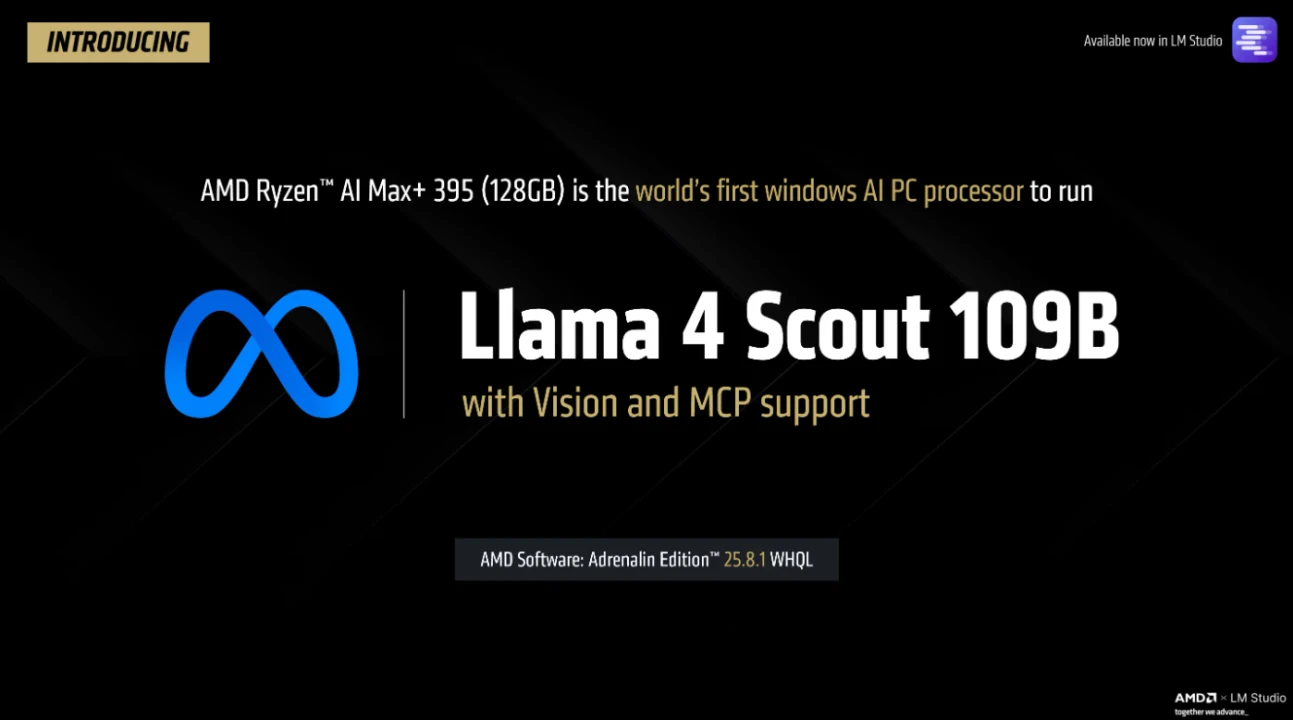

AMD Ryzen AI MAX 系列處理器透過 VGM 技術實現高達 96GB 記憶體,讓如 Meta Llama 4 Scout 等大型 LLM 模型能於本地 PC 運行,將 AI 運算正式帶入消費級設備。

Ryzen AI MAX+ 實現跑 123B 語言模型

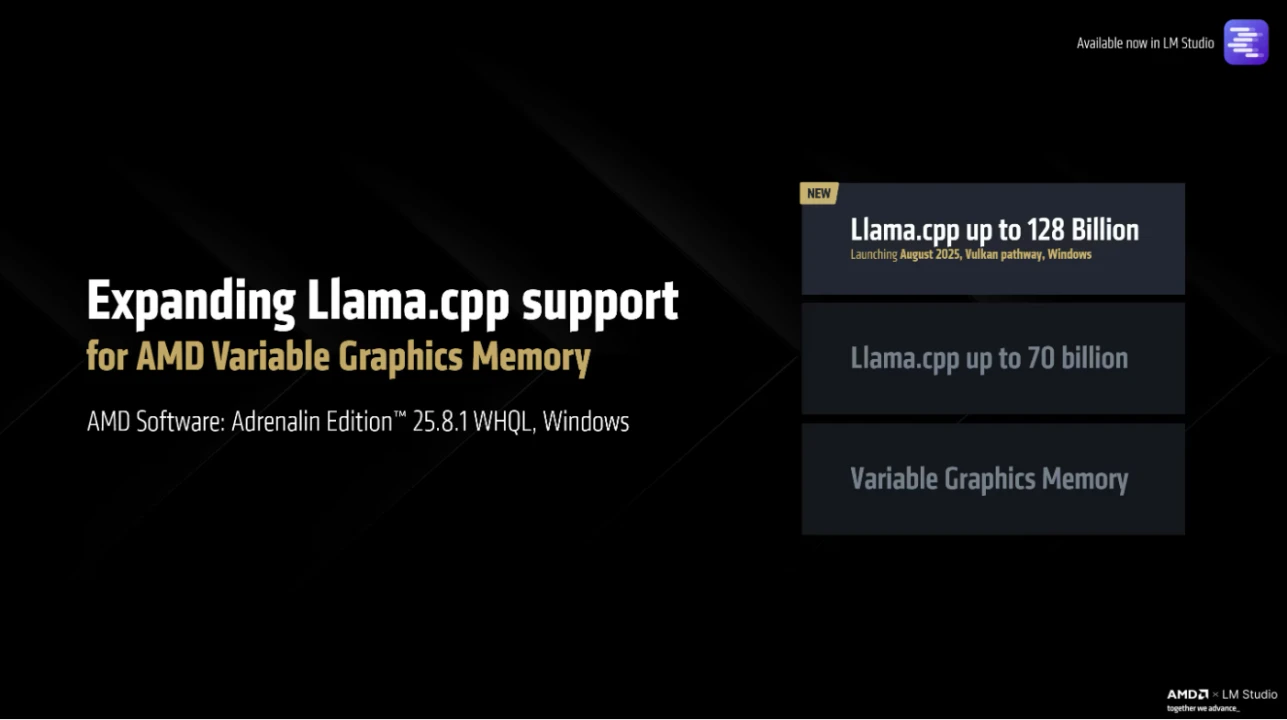

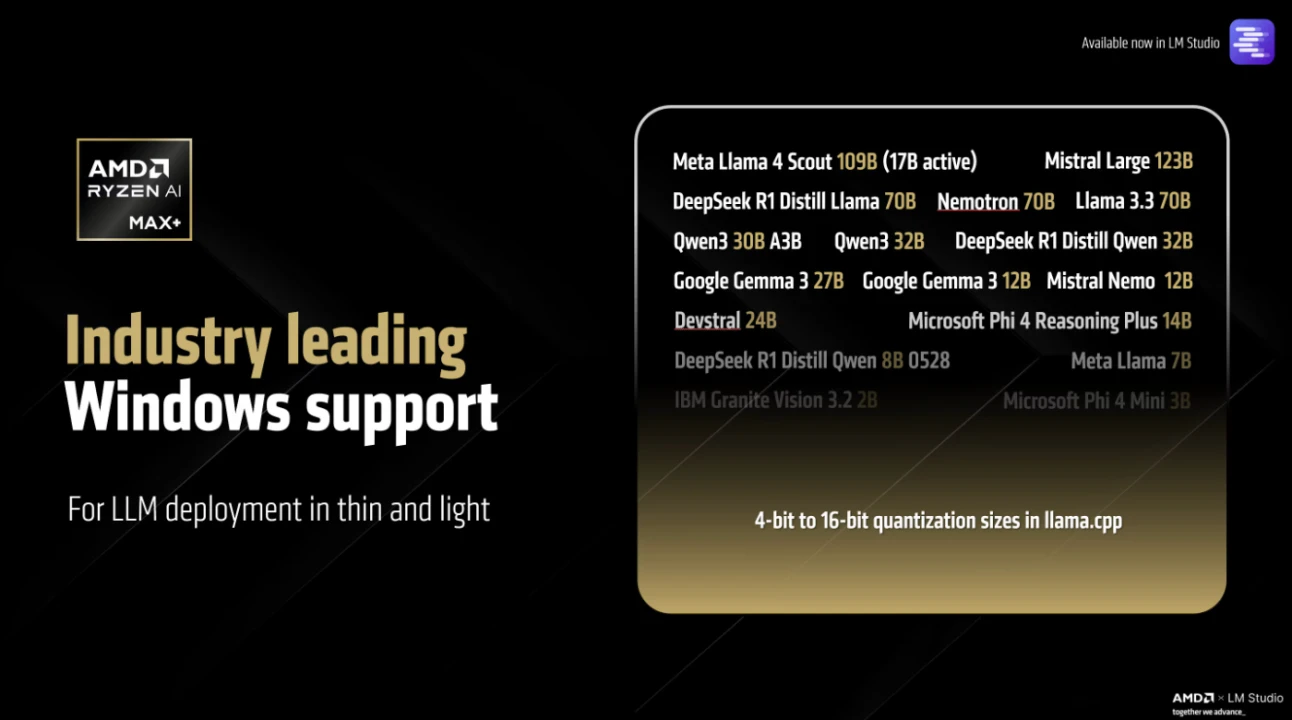

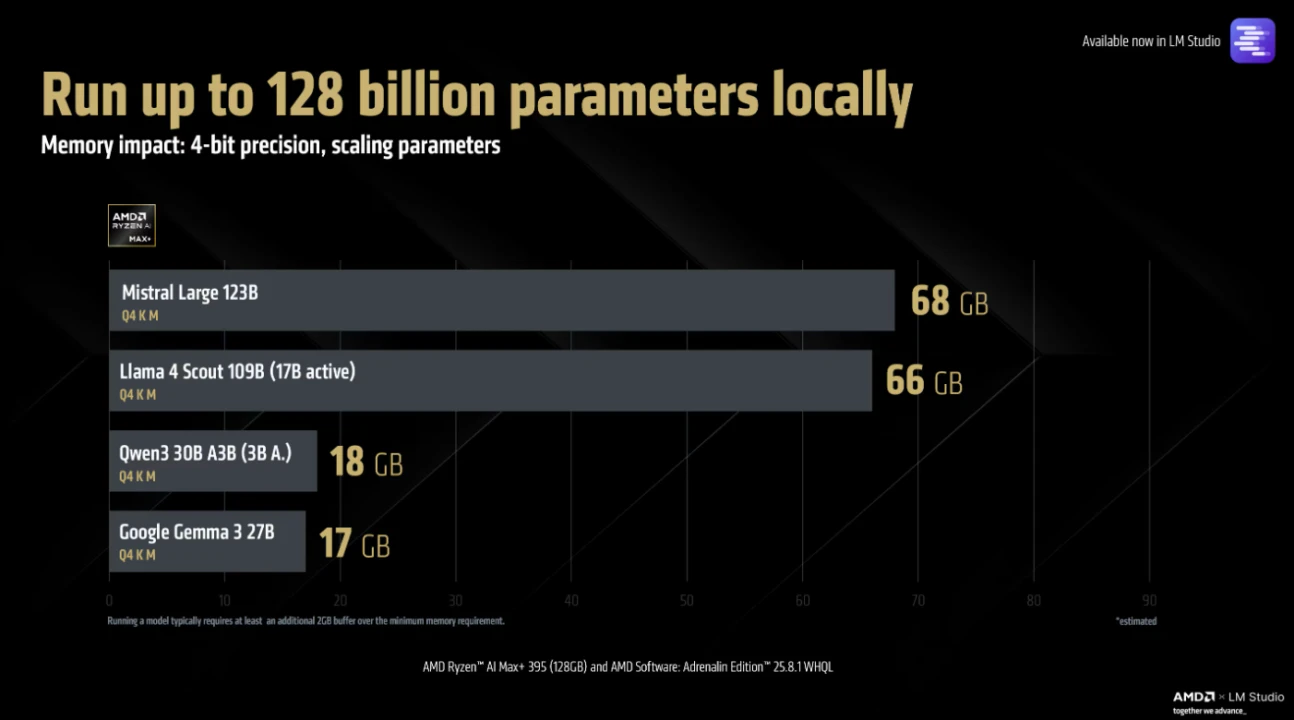

隨著最新 Adrenalin Edition 25.8.1 驅動釋出,AMD 宣布 Ryzen AI MAX+ 系列處理器可在消費級平台上支援高達 128B 參數的大型語言模型,象徵「AI on PC」的可行性正式從概念走向實作。

藉由 AMD 自家 Variable Graphics Memory (VGM,可變顯示記憶體) 技術,iGPU (整合圖形處理器) 最高可配置達 96GB 的共享記憶體,使 AI 模型可直接在終端裝置上進行推論執行,而不需依賴雲端。

這不僅打破 iGPU 傳統受限於記憶體瓶頸的框架,也讓如 Meta Llama 4 Scout 這類使用 MoE 架構 (Mixture-of-Experts) 的 LLM 模型,得以有效率地在 PC 上本地部署與運作。

除了記憶體容量提升外,AMD 更宣布 Ryzen AI MAX+ 處理器的上下文支援長度從傳統的 4096 tokens 一舉拉高至 256,000 tokens,使用者可在處理複雜任務、進行多步邏輯推理與大型文檔摘要時,獲得更佳效能與精準度。

如此大幅擴增的上下文空間,將為開發者與進階 AI 使用者提供前所未有的工作流控制能力,尤其對 LLM 訓練與微調 (fine-tuning) 階段至關重要。

目前支援 Ryzen AI MAX 的 Strix Halo 平台尚屬小眾裝置,普遍售價超過 2,000 美元,但其技術指標所代表的未來方向無庸置疑。隨著更多廠商導入 XDNA 架構與 AMD AI 加速引擎,未來可望在更平價裝置上看到類似功能普及。

這也是 AMD 想傳達的核心訊息之一:AI 運算的門檻正在降低,而消費級設備也能擁有專業級 AI 運行能力。

延伸閱讀